数据投毒让GPU显存暴涨70GB,服务器宕机

随着3D Gaussian Splatting(3DGS)成为新一代高效三维建模技术,它的自适应特性却悄然埋下了安全隐患。在本篇 ICLR 2025 Spotlight 论文中,研究者们提出首个专门针对3DGS的攻击方法——Poison-Splat,通过对输入图像加入扰动,即可显著拖慢训练速度、暴涨显存占用,甚至导致系统宕机。这一攻击不仅隐蔽、可迁移,还在现实平台中具备可行性,揭示了当前主流3D重建系统中一个未被重视的安全盲区。

引言:3D视觉的新时代与未设防的后门隐患

过去两年,3D视觉技术经历了飞跃式发展,尤其是由 Kerbi等人在2023年提出的️3D Gaussian Splatting (3DGS),以其超高的渲染效率和拟真度,一跃成为️替代NeRF的3D视觉主力军。

你是否用过 LumaAI、Spline 或者 Polycam 之类的应用上传图片生成三维模型?它们背后很多就用到了3DGS技术。3D高斯泼溅无需繁重的神经网络,仅靠一团团显式的、不固定数量的3D高斯点即可构建逼真的三维世界。

但你知道吗?这个看起来高效又灵活的“新王者”,居然隐藏着一个巨大的安全隐患——只要改动图片的细节,就能让系统在训练阶段直接崩溃!

来自新加坡国立大学和昆仑万维的研究者在 ICLR 2025上的Spotlight论文《Poison-Splat: Computation Cost Attack on 3D Gaussian Splatting》中,首次揭示了这一致命漏洞,并提出了首个针对3DGS计算复杂度的攻击算法:️Poison-Splat。

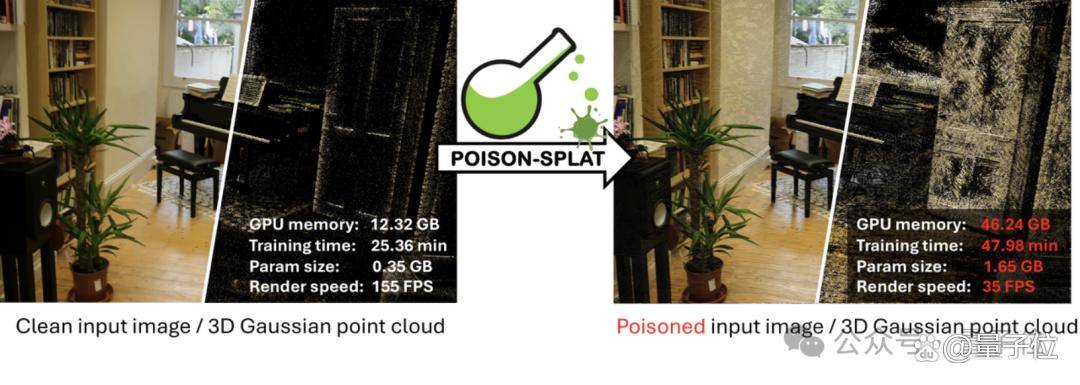

图一:干净(左)与Poison-Splat攻击后(右)的输入图像、三维高斯点云,以及GPU显存、训练时间和渲染速度的显著变化。这里的每张图片由像素表征(左上)和3DGS高斯点的可视化(右下)拼接而成,更好地展示其二维像素空间和三维高斯空间的变化。

问题背景:强大的模型“适应性”是优点,还是漏洞?

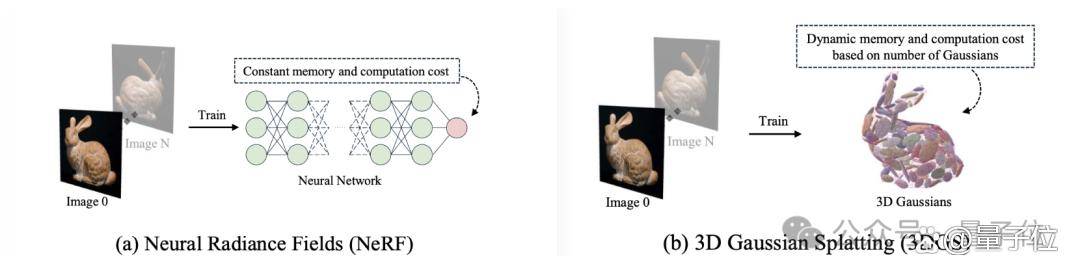

图二:NeRF (左) 和 3D Gaussian Splatting (右) 分别引领了3D视觉的一个时代,但它们的核心思想却截然不同。NeRF (图a) 使用神经网络对三维场景隐式建模,其复杂度和计算成本由训练者通过超参数人为指定;而 3DGS (图b) 使用不固定数量的三维高斯对场景显式建模,其复杂度和计算成本会根据需要建模的三维内容进行自适应调整。

3D Gaussian Splatting 相比于NeRF最大的区别之一,就是它拥有自适应的模型复杂度:

训练过程中,模型会根据图像复杂度自动增加或减少高斯点(3D Gaussian)

图像越复杂,模型训练过程就会产生越多的高斯点 → 占用更多显存、需要更长训练时间

本质上,3DGS会智能地根据建模场景“细节多不多”来决定要分配多少计算资源。

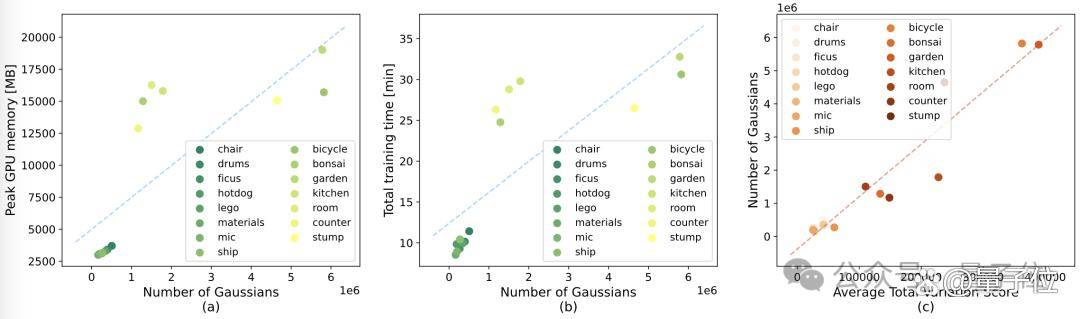

图三:计算成本(GPU显存占用、训练效率)、高斯点数量、数据集图像复杂度之间的强正相关关系。对于不同的数据集场景,(a) GPU显存占用和高斯点数量的关系;(b)训练耗时和高斯点数量的关系;(c) 高斯点数量和图片复杂程度(以Total Variation Score衡量)的关系。